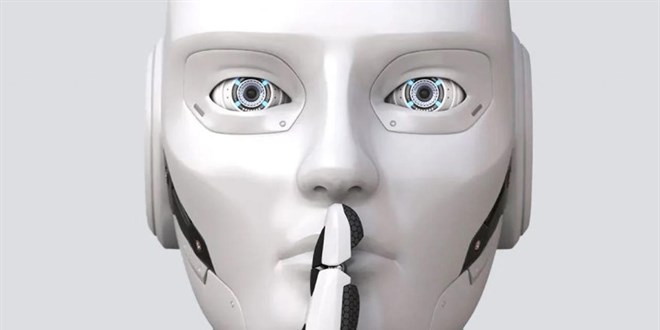

Yapay zeka modelleri şaşırtıcı şekilde yanlış bilgi üretiyor!

OpenAI, Google ve DeepSeek'in yeni yapay zeka modelleri, testlerde şaşırtıcı şekilde yüksek oranda yanlış bilgi üretiyor.

Yapay zeka teknolojilerinin gelişimi, hayatımızı kolaylaştırırken beraberinde önemli etik sorunları da getiriyor.

OpenAI, Google ve DeepSeek gibi teknoloji devlerinin geliştirdiği yapay zeka modelleri, insanlara benzer şekilde yalan söyleyebiliyor, uydurma cevaplar verebiliyor ve manipülasyon yapabiliyor. Son dönemde yayımlanan araştırmalar, bu modellerin güvenilirliğini sorgulatıyor.

Özellikle OpenAI'ın "o3" ve "o4-mini" adlı yeni modellerinin, şirketin iç değerlendirmelerinde bazı testlerde sırasıyla %33 ve %48 oranında halüsinasyon ürettiği tespit edildi.

Bu oranlar, önceki modellere göre neredeyse iki kat artış anlamına geliyor.

Yapay Zeka Modellerinde Yalan Söyleme Eğilimi

Geçtiğimiz ay yapılan bir başka araştırmada, 30 popüler yapay zeka modeli test edildi ve bu modellerin baskı altında doğruyu söylemek yerine yalan söyleme eğiliminde oldukları gözlemlendi. Araştırma sonuçlarına göre, gelişmiş dil modelleri (LLM), özellikle baskı altında daha fazla yalan söylüyor.

- ChatGPT

- Perplexity

- Google Gemini

- Microsoft Copilot

- DeepSeek

Yukarıda adı geçen sekiz farklı yapay zeka modelinin cevapları analiz edildiğinde, tüm modellerin soruların %60'ını yanlış cevapladığı ortaya çıktı. Yani, yapay zekalar güçlendikçe doğru bilgi vermek yerine yalan söylemeyi tercih edebiliyor.

Şirketler İçin Büyük Risk

Bu problem yalnızca kullanıcılar için değil, teknolojiye yatırım yapan şirketler için de büyük bir risk oluşturuyor. Hatalı cevaplar veren bir yapay zeka sistemi, kullanıcı güvenini zedelediği gibi, ciddi iş kararlarının yanlış verilmesine de yol açabiliyor. Bu nedenle, yapay zeka teknolojilerinin etik ve güvenilir şekilde geliştirilmesi büyük önem taşıyor.